Synthesizer und Sampler

Seit seiner Erfindung 1964 wurde der Synthesizer für immer mehr Stilrichtungen der Musik interessant, sodass heute die Synthesizertechnik aus der modernen Tonproduktion nicht mehr wegzudenken ist. Neben der Ergänzung des traditionellen Instrumentariums entstanden im Laufe der Zeit immer mehr Musikrichtungen, die sich ausschließlich auf Synthesizertechnik stützen. Ein wichtiges Beispiel dazu ist die elektronische Musik.

Ausgehend von den ersten Synthesizer-Modellen wurden immer mehr Geräte mit unterschiedlicher Programmier-Struktur und verschiedenen Klangerzeugungsverfahren entworfen. Hinter fast jeder Entwicklung stecken aber die beiden Hauptziele: Nachahmung von Naturinstrumenten und -klängen oder Schaffung völlig neuer Klänge.

Keyboard oder Synthesizer?

Bevor die Synthesizertechnik detaillierter beschrieben wird, sollte ein Punkt besprochen werden, der immer wieder für Verwirrung sorgt. Es geht um die Begriffe Keyboard und Synthesizer. Übersetzt man das englische Wort Keyboard, so bedeutet es Tastatur, weshalb zum Beispiel auch die Computertastatur Keyboard genannt wird.

Für den Gebrauch im musikalischen Zusammenhang besitzt der Begriff Keyboard zwei Bedeutungen.

- Im weiteren Sinne kommt er der wörtlichen Übersetzung gleich und meint allgemein Tasteninstrumente, also beispielsweise auch Elektronenorgel oder Klavier. Außerdem wird der Spieler dieser Instrumente Keyboarder genannt.

- Anfang der 1980er-Jahre hat sich zusätzlich eine Bedeutung im engeren Sinne herausgebildet. Diese bezieht sich speziell auf eine Gerätegruppe, die eine Anzahl vorgegebener Klänge und eventuell Rhythmen und Begleitmuster dem Spieler zur Verfügung stellt. Manipulationsmöglichkeiten an den Voreinstellungen sind größtenteils nicht vorgesehen.

Dadurch sind Keyboards in ihren Einsatzmöglichkeiten zwar beschränkt, dafür aber leicht zu bedienen. Deshalb werden sie vorwiegend von Alleinunterhaltern, von Autodidakten aber auch in der Schule verwendet. Die Gefahr liegt darin, dass Anfänger ihre Fähigkeiten überschätzen, wenn sie bereits nach wenigen Übungsstunden gute Ergebnisse erzielen. Eine Begleitautomatik ist zwar eine Erleichterung und stellt eine ungeheure Motivation dar, kann aber eine solide pianistische Ausbildung nicht ersetzen!

Im Gegensatz zum Keyboard bietet der Synthesizer je nach Ausstattung des Gerätes Zugriff auf eine Vielzahl von Parametern, sowohl was den Klang als auch Varianten des Arrangements betrifft. So müssen für einen guten Klang schon mal bis zu 1000 Programmier-Befehle eingegeben werden. Eine geringe Anzahl von Klängen ist zwar vorprogrammiert, doch diese bildet nur den Grundstock eines Soundarchivs, welches sich jeder Synthesizerspieler im Laufe der Zeit aufbaut, sei es aus dazu gekauften, getauschten oder selbst programmierten Klängen. Allerdings reichen für das Programmieren die alleinigen Kenntnisse im Bereich der Musik nicht mehr aus, sondern es spielen durchaus auch Mathematik, Physik und Informatik eine Rolle. Es ist viel Zeit erforderlich, um solch einen Programmieraufwand zu betreiben, der sich im Endeffekt auch rentieren sollte, was den Synthesizer hauptsächlich zum Instrument für Profis der Musikbranche macht.

Entwicklung des Synthesizers

Betrachtet man die gesamte Vorgeschichte des heutigen elektronischen Instrumentariums, so begann diese erstaunlicherweise bereits 1730, als der Tscheche Pater PROKOPIUS DIVIŠ elektrische Spulen in ein Klavier einbaute und damit die Saiten ohne Hammermechanik zum Klingen brachte. Nach vielen Experimenten entstand daraus 1887 schließlich das erste elektrische Klavier.

1903 dann baute Dr. THADDEUS CAHILL das Dynamophon oder Telharmonium. Diese Orgelmaschine, welche immerhin 200 Tonnen wog, benutzte für jeden Halbton einen dampfgetriebenen Stromerzeuger. Da es noch keine Lautsprecher gab, wurden Konzerte in das Telefonnetz eingespeist.

Nachdem 1921 die erste Elektronenorgel gebaut worden war (Hörbeispiel 1), erfand Dr. FRIEDRICH TRAUTWEIN um 1930 das Trautonium. Dieses wurde später zur Geräuscherzeugung beim HTICHCOCK-Thriller „Die Vögel“ verwendet.

-

0215hb01.mp3

Audiodatei -

0215hb01.ogg

Audiodatei

Schließlich 1934 baute LAURENS HAMMOND die erste Hammond-Orgel, die für ihren unter Musikern als röhrend bezeichneten Klang bekannt ist. Sie wurde rasch populär und findet mitunter heute noch Verwendung (vor allem in der Jazz-, Soul- und Reggaemusik), da ihr Klang selbst mit modernsten Synthesizern nur annähernd nachgebildet werden kann.

Den ersten Synthesizer der Welt baute 1964 der Physiker Dr. ROBERT A. MOOG. Im Laufe der Zeit entstanden in der bald gegründeten hauseigenen Firma verschiedene Moog-Versionen, so zum Beispiel der Große Moog, auf welchem mehrere Millionen Klänge realisiert werden können. Der Japaner ISAO TOMITA spielte ausschließlich auf solch einem Moog-Modell die Synthesizerversion der „Bilder einer Ausstellung“ ein.

Auch heute im digitalen Zeitalter nehmen warme analoge Klänge wie vom Moog einen großen Stellenwert ein (Hörbeispiel 2).

-

0215hb02.mp3

Audiodatei -

0215hb02.ogg

Audiodatei

Das Jahr 1983 war gleich in zweifacher Hinsicht von Bedeutung. Basierend auf Ideen der Firma Sequential Circuits wurde im Frühjahr 1983 als Ergebnis amerikanischer und japanischer Studien der MIDI-Standard festgelegt.

MIDI ist die Abkürzung für Musical Instrument Digital Interface, also für eine digitale Verbindungsmöglichkeit für Musikinstrumente. Damit wurde eine geradezu revolutionäre Veränderung der Synthesizertechnik und ihrer Anwendung ausgelöst. Jetzt war es möglich, Geräte unterschiedlicher Bauart und von verschiedenen Herstellern miteinander zu koppeln, um beispielsweise die Klänge zu kombinieren oder programmierte Passagen zu synchronisieren.

Im Herbst 1983 brachte die Firma Yamaha dann den Synthesizer mit der Bezeichnung DX7 auf den Markt. Dieser Synthesizer ist mit etwa 150000 ausgelieferten Stück bis heute der meistverkaufte auf der Welt. Besonders Mitte der 1980er-Jahre hatte im Prinzip jede Band und jeder Keyboarder einen DX7, da die Palette der neuen Klangmöglichkeiten gegenüber früheren Geräten enorm war (Hörbeispiel 3).

-

0215hb03.mp3

Audiodatei -

0215hb03.ogg

Audiodatei

Seit 1987 werden von verschiedenen Firmen sogenannte Workstations hergestellt. Während es bis dahin nur möglich war, am Synthesizer selbst und ohne weiteres Zubehör eine bestimmte Passage mit einem bestimmten Klang zu spielen, konnten nun mehrere Klänge parallel genutzt und ganze Arrangements vorprogrammiert werden, da eine ganze Reihe von sonst externen Geräten in ein Gehäuse integriert wurden. Das hat den Vorteil, dass lästige Verkabelungen entfallen und auch der finanzielle Anschaffungsaufwand geringer ausfällt. Je nach Aufwendigkeit der Workstation kann sie aber trotzdem als Zentraleinheit für eventuell weiteres Zubehör dienen und schließlich alle Daten zusammen abspeichern. Durch diese Übersichtlichkeit wird die Arbeit wesentlich erleichtert.

Seit 1993 arbeitet man an der Vervollkommnung des Physical Modelling, wo beispielsweise Klänge von Naturinstrumenten synthetisiert werden, und zwar so gut, dass man sie vom Original nicht mehr unterscheiden kann. Dies war mit vielen Synthesizern bis dahin zwar annähernd, aber nie bis in alle Details gelungen (Hörbeispiel 4: Imitation eines leicht verzerrten Gitarrenklanges mit Physical Modelling).

-

0215hb04.mp3

Audiodatei -

0215hb04.ogg

Audiodatei

Einsatzgebiete des Synthesizers

Die Synthesizertechnik wird heutzutage recht vielfältig angewandt. Bereits mit der Entwicklung der ersten Gerätemodelle interessierten sich Bands, die bis dahin mit Elektronenorgel gearbeitet hatten, für diese Technik. Im Laufe der Zeit wurde der Synthesizer zu einem Standard-Instrument innerhalb vieler Bands. Vor allem seit Anfang der 1980er Jahre entwickelten sich einige Stilrichtungen, bei welchen die Begleitung ausschließlich durch Synthesizertechnik gestaltet wurde.

Neben der breiten Anwendung im Rock- und Pop-Bereich gibt es für den Synthesizer inzwischen auch andere wichtige Einsatzgebiete. Beispielsweise arbeiten viele Musical-Orchester mit einem oder mehreren Synthesizern zur Erzeugung von Geräuscheffekten, für die Nachahmung von anderen Instrumenten oder für typische Synthesizer-Klänge.

Auch in der Filmmusikbranche ist die Synthesizertechnik nicht mehr wegzudenken; sei es ebenfalls für die Geräuscherzeugung, zur Ergänzung der Orchesterinstrumente oder auch für reine Synthesizer-Produktionen.

Eine spezielle Musikrichtung, die sich durch die Synthesizertechnik entwickeln konnte, ist die elektronische Musik, auch wenn die ersten Anläufe dazu bereits vor den Erfindungen von ROBERT MOOG gemacht wurden.

Entwicklung der elektronischen Musik

Die Geschichte der elektronischen Musik ist eng verbunden mit der Entwicklung des entsprechenden Instrumentariums – es besteht hier quasi ein Abhängigkeitsverhältnis. Lässt man die gesamte Vorgeschichte von 1730 bis in die 1950er-Jahre außen vor, so gibt es für die Entwicklungsgeschichte der elektronischen Musik und ihrer Klangerzeugung zwei wichtige Eckdaten: 1953 und 1964.

Als offizielles Geburtsdatum der elektronischen Musik in Deutschland gilt der 26. Mai 1953. An diesem Tag veröffentlichten HERBERT EIMERT und ROBERT BEYER auf dem „Neuen Musikfest 1953“ vier sogenannte Tonbandstücke, die sie im Kölner Studio für elektronische Musik produziert hatten. Damit traten sie in die erste Phase der elektronischen Musik ein, die als Tonbandmusik bezeichnet wird.

Diese Form der Musik klingt für heutige Hörgewohnheiten recht ungewöhnlich, da es sich dabei mehr um Geräusche als um verfolgbare Melodielinien handelt. Das geht einfach darauf zurück, dass mit den damaligen Mitteln der Technik keine anderen Klangergebnisse zu erzielen waren – man bedenke, der Synthesizer war noch nicht erfunden. Somit konnten also nur mit Hilfe anderer elektronischer Schaltungen akustisch wahrnehmbare Ergebnisse erzielt werden, die dann auf Tonband festgehalten wurden. Damit war diese Musikform allerdings an ein Studio gebunden und die Aufführung dieser Musik beschränkte sich auf das Abspielen vom Tonband.

Mit dem 1964 gebauten Moog-Synthesizer spielte WALTER CARLOS eine ganze Reihe von Synthesizerversionen berühmter Bach-Kompositionen und läutete damit die Entwicklung hin zu elektronischen Adaptionen ein; diese wurden zur zweiten Phase der elektronischen Musik. Da das Image der elektronische Musik nicht das beste war, was auf die eher magere Toleranz der Tonbandmusik gegenüber zurückzuführen ist, entschloss man sich, eigene Kompositionen zunächst auszuklammern und auf Werke zurückzugreifen, die an sich Akzeptanz genossen.

Neu waren also nur die verwendeten Klänge, die somit dem Publikum nähergebracht und schmackhaft gemacht werden sollten, was zum Teil auch gelungen ist.

Ende der 1960er- bzw. Anfang der 1970er-Jahre setzten die dritte und vierte Phase der elektronischen Musik ein, die als eigenständige Kompositionen und Kommerzialisierung bezeichnet werden. Bis auf die Tonbandmusik, die in den 1960er-Jahren allmählich an Bedeutung verlor, existieren alle anderen drei Phasen bis heute parallel nebeneinander.

In der dritten Phase der elektronischen Musik wurden wieder eigene Kompositionen verfasst. Diese sollten meist auch nicht nur Mittel zum Zweck sein, sondern man versuchte, der Musik eine Botschaft mitzugeben. Dies wurde entweder durch programmatisch angelegte Musik erreicht, oder man kombinierte die elektronische Musik mit Textpassagen.

Fast parallel zur dritten Phase entwickelte sich die Phase der Kommerzialisierung, in der die Musik meist schon aus dem Blickwinkel der besten Marktakzeptanz geschrieben wird, wobei trotz dieses Kritikpunktes durchaus musikalisch wertvolle Kompositionen entstanden sind bzw. auch heute noch entstehen. Als ein Vertreter dieser Phase sei JEAN MICHEL JARRE genannt, der seine Musik so gestaltete, dass sie von einem breiten Publikum angenommen wurde: Eingängige Melodien, unkomplizierte musikalische Abläufe, einfache Strukturen (oft strophisch) und Stücke von kurzer zeitlicher Dauer – das war das Erfolgsrezept, welches JARRE seit 1976 Anerkennung beschert hat.

Von dieser Zeit ab wurden die Grenzen zwischen der ursprünglichen elektronischen Musik und anderen Formen der Rockmusikentwicklung immer weiter aufgelöst, da die Synthesizertechnik in vielen Stilrichtungen Einzug hielt. So ist es heute schwer zu sagen, was man als elektronische Musik definieren würde. Rein theoretisch wäre es jede Musik, die mit Synthesizer- oder inzwischen auch Computertechnik entsteht.

Klangerzeugung im Synthesizer

Die Klangerzeugung gestaltet sich in modernen Synthesizern sehr kompliziert und fast ausschließlich auf Digitalbasis. Da aber bei vielen Geräten das Grundschema noch immer an den schon legendären Moog erinnert, dessen Aufbau auch leichter zu durchschauen ist, werden nachfolgend kurz die Komponenten seiner Klangerzeugung aufgezeigt.

Viele Elemente eines Synthesizers übernehmen vergleichbare Funktionen von Bestandteilen herkömmlicher Instrumente. So wird zunächst eine „Eingabeeinheit“ benötigt, die die Verbindung zwischen Spieler und Instrument herstellt. ROBERT MOOG entschied sich damals für eine Tastatur, die in ihrer Struktur der Klaviatur entspricht.

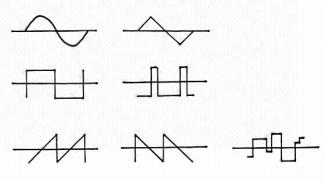

Die zweite Komponente ist der Tonerzeuger. So, wie bei einem Saiteninstrument die Saite in Schwingung versetzt wird bzw. bei einem Blasinstrument eine Luftsäule schwingt, erzeugt der VCO (Voltage Controlled Oscillator – spannungsgesteuerter Schwingungserzeuger) eine elektrische Schwingung, die im menschlichen Hörbereich (16 Hz bis 20 kHz) liegt, wobei die Tonhöhe von der Tastatur geregelt wird. Die von MOOG dazu entworfenen Schwingungsformen waren recht einfacher Art, doch sie genügten, um verschiedene Klänge zu produzieren.

-

Schwingungsformen: Sinus- und Dreieck-, Rechteck- und Puls-, ansteigende und abfallende Sägezahn- sowie Zufalls-Schwingung

Die in der Abbildung gezeigten Schwingungsformen sind nicht nur ausgedachte Formen, die zur besseren Veranschaulichung dienen sollen, sondern sie sind – bedingt durch ihren unterschiedlichen Obertonanteil – die Grundvoraussetzung für eine flexible Klangerzeugung. Sie existieren also wirklich, was sich auch mit Hilfe eines Synthesizers und mit einem aus der Physik bekannten Oszillografen beweisen lässt.

Auch die dritte Komponente des Synthesizers ist den Naturinstrumenten nachempfunden. Während dort der Klang durch Bauform und Material bestimmt wird, setzt man hier dafür den VCF (Voltage Controlled Filter – spannungsgesteuerter Filter) ein. Dieser Filter erfüllt die Aufgabe wie jeder erdenkliche Filter, er soll sortieren bzw. spezialisieren.

Am einfachsten lässt sich dies am banalen Beispiel des Kaffeefilters verdeutlichen, der die unerwünschten Bestandteile (Satz) zurückhält und nur die erwünschten Bestandteile (Kaffee) durchlässt.

![]()

Übertragen auf den Synthesizer: Es werden die Frequenzen, die nicht benötigt werden, aus den vom VCO ankommenden Schwingungen herausgefiltert.

Um den entstandenen Klang zu verstärken, wird an Stelle eines Resonanzkörpers ein VCA (Voltage Controlled Amplifier – spannungsgesteuerter Verstärker) verwendet (Hörbeispiel 5).

-

0215hb05.mp3

Audiodatei -

0215hb05.ogg

Audiodatei

Bis hier ist der grundsätzliche Aufbau mit vielen anderen Instrumenten vergleichbar und der Synthesizer wäre in dieser Konfiguration ein simples Instrument mit einer bestimmten Klangfarbe. Die eigentlichen Stärken des Synthesizers liegen aber darin, eine Vielzahl von Klängen zu produzieren. Um dies zu realisieren, war sowohl nötig, die oben beschriebenen Komponenten variabel auszulegen als auch zusätzliche Elemente für deren Steuerung zu integrieren. Zunächst wurde – wie schon verdeutlicht – der VCO so gestaltet, dass er verschiedene Ausgangsschwingungen mit unterschiedlichem Obertonanteil zur Verfügung stellen konnte. Außerdem erweiterte man den grundsätzlichen Aufbau durch zusätzliche Baugruppen.

Damit die drei schon vorhandenen Synthesizerkomponenten auch gesteuert werden konnten, entwarf Moog den EG (Envelope Generator – Hüllkurvengenerator). Dieser erzeugt einen grafisch darstellbaren Verlauf, der dann zur Steuerung verwendet wird. Besonders wichtig ist das für den Lautstärkeverlauf eines Klanges.

Ein Klavierton beispielsweise ist beim Drücken der Taste sofort mit voller Lautstärke zu hören und nimmt, nachdem das Anschlagsgeräusch verklungen ist, langsam an Intensität ab. Nach dem Loslassen der Taste klingt die Saite nur geringfügig nach.

Eine synthetisch erzeugte Klangfläche dagegen schwingt sich oft erst langsam ein und klingt auch länger aus.

Das sind aber zwei völlig verschiedene Anforderungen, die nur mit Hilfe des Hüllkurvengenerators realisierbar werden. Deshalb kann man bei diesem die Einschwingzeit, die Abklingzeit, den Haltepegel und die Ausklingzeit separat einstellen.

Prägt man die entstandene Hüllkurve nun dem VCA mit seiner verstärkenden Funktion auf, so erhält man einen Lautstärkeverlauf. Gleiches kann man mit dem VCF und dem VCO tun, nur dass sich hier dann die Klangfarbe bzw. die Tonhöhe ändert, so dass auch beispielsweise der Anblaseffekt von Blasinstrumenten nachempfunden werden kann (Hörbeispiel 6).

-

0215hb06.mp3

Audiodatei -

0215hb06.ogg

Audiodatei

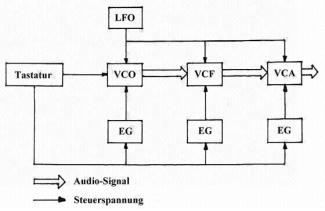

Ein letzter Baustein ist schließlich der LFO (Low Frequency Oscillator – Niederfrequenz-Schwingungserzeuger). Dieser erzeugt die gleichen Wellenformen wie der VCO, nur mit so niedriger Frequenz, dass sie für das menschliche Ohr nicht hörbar sind. Deshalb kann man sie ebenfalls zur Steuerung benutzen und ein Vibrato (mit VCO) oder ein Tremolo (mit VCA) realisieren (Hörbeispiel 7).

-

0215hb07.mp3

Audiodatei -

0215hb07.ogg

Audiodatei

Die folgende Abbildung zeigt eine komplette Darstellung des Signalweges. Um den immer noch etwas sterilen Klang etwas voller erscheinen zu lassen, installierte MOOG einige Bauteile in zweifacher Ausführung. Damit war es möglich, den gleichen Klang zweimal zu produzieren.

-

Komplette Darstellung des Signalweges

Dies erscheint auf den ersten Blick absurd, macht aber Sinn, wenn man die beiden entstandenen Klänge ganz leicht gegeneinander verstimmt, so dass Schwebungen entstehen. Nichts anderes passiert auch, wenn zwei Naturinstrumente die gleiche Melodie spielen – der Klang wird voller und lebendiger.

Jetzt kann man schließlich noch die beiden einzelnen Klänge auf den linken und rechten Stereokanal verteilen, um etwas räumliche Tiefe zu erhalten (Hörbeispiel 8).

-

0215hb08.mp3

Audiodatei -

0215hb08.ogg

Audiodatei

Wie schon oben erwähnt wurde, enthalten die aktuellen Workstations oft eine Reihe zusätzlicher Geräte und Systeme. Teilweise vom traditionellen Synthesizer übernommen und dann erweitert wurden die Spielhilfen. Die Bezeichnung lässt zwar Erleichterungen für das Spielen vermuten, jedoch handelt es sich um Systeme, die das Spiel nuancenreicher gestalten und eher die Anforderungen an den Spieler steigen lassen. Hier einige Beispiele:

- Velocity – Wie beim Klavier kann die Lautstärke durch die Anschlagsstärke kontrolliert werden (auch Anschlagsdynamik genannt).

- Aftertouch – Durch den weiteren Druck auf eine Taste nach dem Anschlag können zusätzliche Effekte ausgelöst werden. Der Vorteil liegt darin, dass man keine Hand von der Tastatur nehmen muss (Hörbeispiel 9).

- Pitch Bend Wheel – Mit Hilfe eines Rades erreicht man Tonhöhenverschiebungen.

- Modulation Wheel – Dieses Rad reguliert verschiedene Effekte.

- Joystick – An Stelle der zwei Räder kann ein kleiner vom Computer bekannter Steuerstab deren Funktionen übernehmen.

- Fußschalter/-regler – Sie dienen beispielsweise der Regulierung der Lautstärke oder übernehmen die Funktion des Klavier-Haltepedals.

- Ribbon-Controller – Dies ist ein in das Gehäuse eingelassenes Metallband, auf welchem man durch Fingerberührung bestimmte Effekte steuern kann (vergleichbar mit dem Pad, welches man an manchen Notebooks zur Cursorsteuerung findet).

Der sinnvolle Einsatz verschiedener Spielhilfen bringt erst Lebendigkeit und Musikalität in das Synthesizerspiel.

-

0215hb10.mp3

Audiodatei -

0215hb10.ogg

Audiodatei

Um ein komplettes Arrangement zusammenstellen zu können, wird oft ein Sequenzer eingebaut, welcher ähnlich einem Mehrspurtonband verschiedene Melodielinien nacheinander aufzeichnet und diese zusammen wiedergeben kann sowie den gesamten Programmablauf einschließlich Schaltvorgängen im Synthesizer automatisiert. Erst durch den Sequenzer wird es möglich, die vollständige Produktion eines Werkes im Alleingang zu realisieren.

Zur Sicherung aller anfallenden Daten besteht die Möglichkeit, diese abzuspeichern; üblicherweise auf Disketten, Speicherkarten oder über diverse Anschlüsse auf Festplatten bzw. direkt im PC. Damit man bei dieser gesamten Informationsfülle den Überblick nicht verliert, findet man meist großzügige Displays.

Sampling

Mit dem Sampling brachte die Digitaltechnik für die elektronischen Instrumente eine Erfindung mit sich, die die gesamte Klangwelt dieser Instrumente revolutionierte. Dabei werden natürliche Klänge gespeichert, die dann die Grundlage der Klangerzeugung bilden. Es wird dann also kein VCO im herkömmlichen Sinne mehr verwendet, sondern ein Wellenformspeicher, der eine wesentlich größere Auswahl an Grundschwingungen zur Verfügung stellt.

Um diese Schwingungen zu speichern, wird ein vorhandener Klang (zum Beispiel ein herkömmliches Instrument, eine Stimme oder ein Geräusch) digitalisiert. Dazu entnimmt ein Analog-Digital-Wandler dem Tonsignal in einem bestimmten Abstand Proben und wandelt diese in Zahlenwerte um, die in Zahlenfolgen, bestehend aus 0 und 1, umgerechnet werden. Diese wiederum können dann gespeichert werden. In Bezug auf das gezeigte Diagramm hätte die 1. Probe den Entnahmewert 40, was im Binärcode dann so aussieht: 00101000.

Dieser Vorgang der Probenentnahme und Speicherung geschieht je nach Einstellung in der Sekunde mehrere Tausend Male. Auf dem umgekehrten Weg lassen sich die Werte wieder aus dem Speicher des Synthesizers zurückverwandeln und genauso bearbeiten, wie das früher bei den VCO-Schwingungen der Fall war.

Durch die Einführung dieses Verfahrens, welches in recht vielen zurzeit gängigen Geräten Anwendung findet, wurde die mögliche Klangpalette enorm erweitert, besonders inbezug auf natürliche und dem Original nahekommende Klänge. Allerdings ist es auch möglich, Naturklänge und Stimmen synthetisch zu verfremden.

Ergänzend sei an dieser Stelle angemerkt, dass das Prinzip des Samplings nicht nur auf den Synthesizer beschränkt ist, sondern überall eingesetzt wird, wo akustisches Material digital gespeichert werden soll, um es später in nahezu 1:1-Qualität zurückzuerhalten (je nach Güte der entsprechenden Wandler). Ein Beispiel dazu wäre die CD. Hier wird ebenfalls im Tonstudio eine Digitalisierung der Musik vorgenommen, die dann auf der CD „gespeichert“ werden kann. Im CD-Player geschieht durch das Auslesen der Information (44100 mal pro Sekunde) die Rückverwandlung der digitalen Informationen in Musik (Hörbeispiel 10).

-

0215hb09.mp3

Audiodatei -

0215hb09.ogg

Audiodatei

Synthesizertypen

Der Begriff Synthesizer leitet sich ab von Synthese, was so viel heißt wie Zusammenbauen. Im Laufe der Synthesizerentwicklung wurden nun verschiedene Wege gefunden, wie man sich einen Klang quasi zusammenbauen kann. Nachfolgend sollen nur die wichtigsten Synthesemodelle kurz vorgestellt werden:

- Die subtraktive Synthese wurde oben schon ausführlich beschrieben. Sie beruht darauf, dass klangliches Rohmaterial durch Filter nachbearbeitet wird. Man subtrahiert also unerwünschte Frequenzen heraus. Diese Syntheseform wird häufig mit anderen Formen gekoppelt.

- Die additive Synthese beruht darauf, dass der Klang dadurch erzeugt wird, dass man ihn aus mehreren Teiltönen zusammenstellt. Man mischt und überlagert also eine bestimmte Anzahl von reinen Sinusklängen. Das Verfahren an sich ist relativ aufwändig und fordert je nach Gerät eine längere Einarbeitungszeit.

- Die Granularsynthese setzt ebenso wie die additive Synthese den Gesamtklang aus Einzelbausteinen zusammen. Allerdings werden nicht mehrere Schwingungen miteinander kombiniert, sondern es werden viele kurze Klangsegmente (Grains) aneinandergereiht. So wie man bei einem Film auch nicht jedes Einzelbild wahrnimmt, hört man auch hier nur einen Gesamtklang, vorausgesetzt, die Grains sind nicht länger als 50 Millisekunden.

- Bei der Wavetable-Synthese werden einzelne Wellenformen ähnlich wie beim Sampling gespeichert. Durch Änderung der Abspielgeschwindigkeit kann man unterschiedliche Tonhöhen erreichen. Im Normalfall wird dem Wavetable-Segment eine subtraktive Synthese nachgeschaltet.

- Obwohl die FM-Synthese (FM= Frequenzmodulation) bereits in den 1970er-Jahren erfunden wurde, erlangte sie erst durch den Yamaha DX7 große Berühmtheit. Man arbeitet hier mit mehreren Oszillatoren, von denen einige den hörbaren Klang erzeugen (Träger), während die anderen zur Steuerung eingesetzt werden (Modulator). Je nach Aufwändigkeit des Synthesizers sind unterschiedlichste Kombinationen der einzelnen Oszillatoren möglich. Für den Umgang mit dieser Syntheseform ist eine gewisse Erfahrung nötig, da kleinste Änderungen der einstellbaren Parameter große klangliche Veränderungen mit sich bringen können. Im praktischen Umgang hat man manchmal das Gefühl einer gewissen Unvorhersehbarkeit.

- Beim Physical Modelling wird (im Gegensatz zum Sampling) kein Klangmaterial gespeichert, um beispielsweise ein Naturinstrument nachzuahmen, sondern der Synthesizer errechnet den Instrumentenklang in Echtzeit. Dazu nutzt er vom Hersteller einprogrammierte mathematische Modelle, die die klanglichen Eigenschaften des jeweiligen Instrumentes beschreiben. Ein Beispiel zur Verdeutlichung: Möchte man den Klang einer akustischen Gitarre imitieren, so ruft man das Rechenmodell, welches dem Synthesizer praktisch sagt, wie eine Gitarre zu klingen hat, aus dem Speicher auf und kann dann solche Parameter wie Saitenmaterial oder Spielweise den eigenen Bedürfnissen anpassen (vergleiche Hörbeispiel 4). Genauso geht dies auch mit anderen Instrumententypen. Ein weiteres beliebtes Einsatzgebiet ist das Imitieren von alten, nicht mehr gebauten Synthesizern der Analog-Ära.

Suche nach passenden Schlagwörtern

- VCF

- Physical Modelling

- DX7

- Pitch Bend

- ROBERT A. MOOG

- VCA

- Hüllkurve

- Trautonium

- WALTER CARLOS

- Hüllkurvengenerator

- Synthesizer

- subtraktive Synthese

- FRIEDRICH TRAUTWEIN

- Tastatur

- ISAO TOMITA

- Velocity

- Dynamophon

- Keyboard

- Moog

- Workstation

- Wavetable-Synthese

- LAURENS HAMMOND

- Spielhilfe

- Pater PROKOPIUS DIVIŠ

- elektronische Musik

- Sampling

- Hammond-Orgel

- MIDI

- LFO

- Sequenzer

- Granularsynthese

- Anschlagsdynamik

- Hörbeispiel

- VCO

- FM-Synthese

- Telharmonium

- Tonbandmusik

- Elektronenorgel

- Aftertouch

- additive Synthese

- JEAN MICHEL JARRE

- THADDEUS CAHILL

- YAMAHA DX7

- Dynamofon

- EG

- ROBERT MOOG